你的文章標題

你的 Markdown 內容...

你的 Markdown 內容...

Anthropic 近期為其 AI 模型 Claude 推出了名為「Skills」的革命性功能,這不僅僅是一次小更新,而是從根本上改變我們設計 AI 工作流程與智能代理(AI agents)的遊戲規則。許多人對 Skills、MCP(Meta-level Control Protocol,元級控制協議)和 Projects 之間的關係感到困惑,甚至誤以為 Skills 只是為了修復 MCP 的問題。事實上,這是一個巨大的誤解。本文將深度解析 Claude Skills 的真正潛力,並透過實戰教學,展示如何立即應用這項功能,打造專屬於你的高效 AI 助理。 簡單來說,你可以將 Claude Skills 理解為「可重複使用的指令手冊」。它教導 Claude 如何按照你的特定要求、

AI 總是不聽話、給出的答案亂七八糟?你可能用錯方法了!在這場深度訪談中,AI 專家 Amir 揭示了 Anthropic 最新推出的殺手級功能——Claude Skills,並現場展示如何將其打造成一個個「數位員工」,解決 AI 最令人頭痛的不可靠問題。本文將帶你深入了解 Skills 與傳統的專案 (Projects) 和子代理 (Sub-agents) 有何天壤之別,並透過三個實戰案例,教你如何打造出能精準執行重複性任務、永不犯錯的 AI 助手。 在深入 Skills 之前,我們必須先理解過去的作法有哪些瓶頸。 首先是 專案 (Projects),這像是為團隊打造的共享工作區,你可以設定系統指令、提供相關文件作為「記憶」,並連接外部工具。這對於協作很有幫助,但問題在於你必須不斷手動更新背景資料,而且當資料過於龐雜時,會出現「脈絡腐爛」(Context Rot) 的問題。

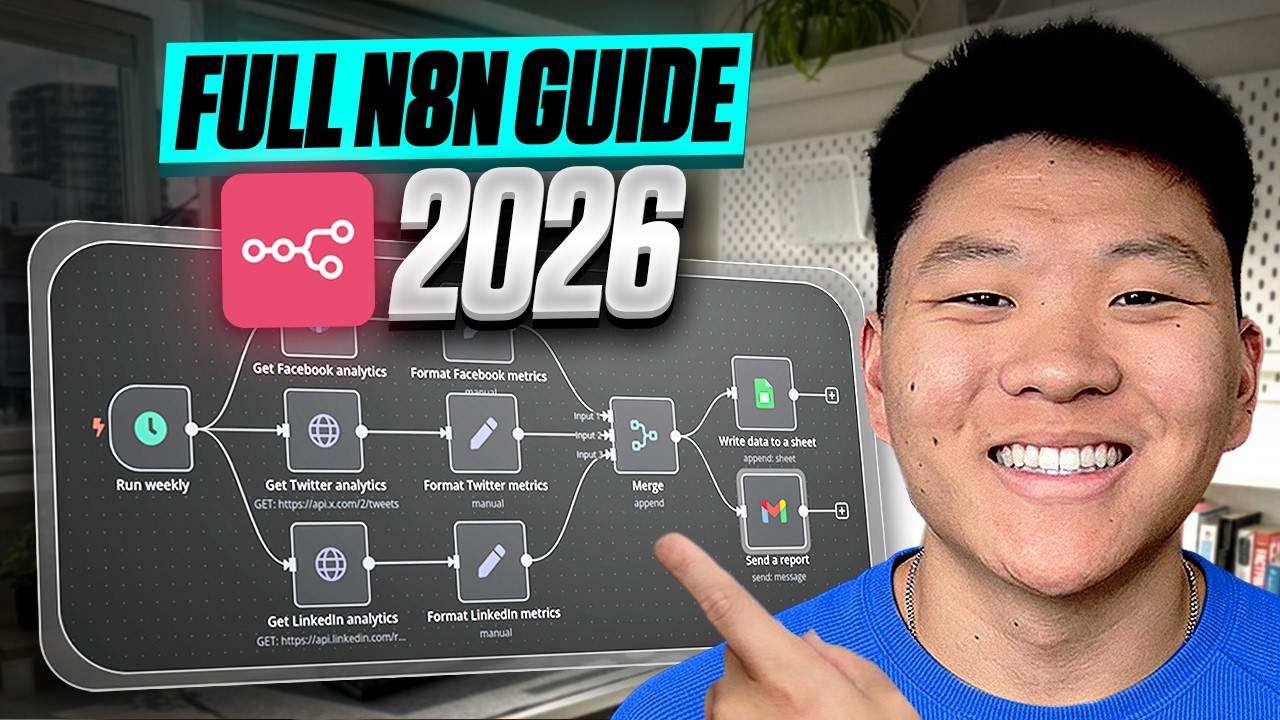

AI自動化專家 Nate Herk 在最新的分享中,拋出了一個顛覆許多人認知的觀點:如果你想精通 n8n 這類自動化工具,最錯誤的起點就是直接跳進去打造酷炫的 AI 代理人(AI Agents)。他坦言,自己初學時也犯了同樣的錯,只想著「盡快做出 AI」,卻忽略了最關鍵的核心。如果時間能倒流,他會採取截然不同的學習路徑。這篇文章將深度解析 Nate Herk 提出的反直覺學習藍圖,告訴你為何掌握「無聊」的工作流程,才是通往真正強大 AI 自動化的唯一道路。 大多數初學者都急於打造 AI 代理人,因為它們看起來很酷,是網路上的熱門話題。但 Nate Herk 警告:「這就像還不會走路就想學跑。」他強調,如果你不了解工作流程的運作原理,你永遠無法建立出穩定可靠的 AI 代理人。 他將自動化分為三個層次: 1. 工作流程 (Workflows)

【我如何用 Google NotebookLM,將1小時的混亂發言,變成1張秒懂的資訊圖表】 老實說,我一直在找一個能完美解決「輸入、整理、輸出」的 AI 工具。市面上的工具很多,輸入不成問題,整理摘要也做得不錯,但到了「輸出」這一步,總覺得少了點什麼。大多工具給你的,就是一堆文字、一串重點,乾巴巴的,很難讓人一眼就抓住精髓。 直到我最近用到了 Google 的 NotebookLM,才真的有種「就是這個了!」的感覺。它在輸出的環節,特別是視覺呈現上,是我目前看過最驚豔的,沒有之一。 你有沒有過這種感覺?開了一場長達一小時的會議,或是跟客戶、朋友聊了半天,腦袋裡的東西像一團打結的毛線,跳躍又發散。你想把這些內容整理給別人看,卻發現光是條列式重點,根本無法傳達當下的思緒脈絡。對方看了半天,還是抓不到你真正想講的主線是什麼。 我就是這樣。我的思緒常常很跳 Tone,