如何從網上陌生人偷學 AI?Jeff Su 揭露 3 步驟加速成長的秘密!

在 AI 快速演進的時代,如何高效學習新技能成為眾多學習者的痛點。知名 YouTube 創作者 Jeff Su 在他的最新影片中,分享了一種源自教育理論的實用方法:透過「鷹架式學習」(scaffolding)來觀察陌生人的 AI 創作過程,從而加速自身進步。Jeff Su 作為一位專注生產力和科技分享的內容創作者,這次示範了如何利用免費工具,從零開始掌握 AI 應用,讓觀眾不僅理解概念,更能立即實踐。

鷹架式學習源自教育領域,指的是提供臨時支持,讓學習者逐步掌握超出當前能力的複雜任務。Jeff Su 強調,這種方法不僅適用於傳統教學,在 AI 學習中同樣強大。他表示:「在教育中,有一個概念叫 scaffolding。它是用臨時支持來學習超出你目前能力範圍的東西。我至今仍用它來提升 AI 技能。」

這種方法的核心在於「借力」他人經驗,避免從頭摸索。Jeff Su 指出,AI 學習常因缺乏實戰範例而卡關,但透過觀察真實創作過程,能大幅縮短學習曲線。根據教育研究,這種支持性學習可將掌握新技能的時間縮減 30% 以上,讓初學者從被動閱讀轉為主動模仿。

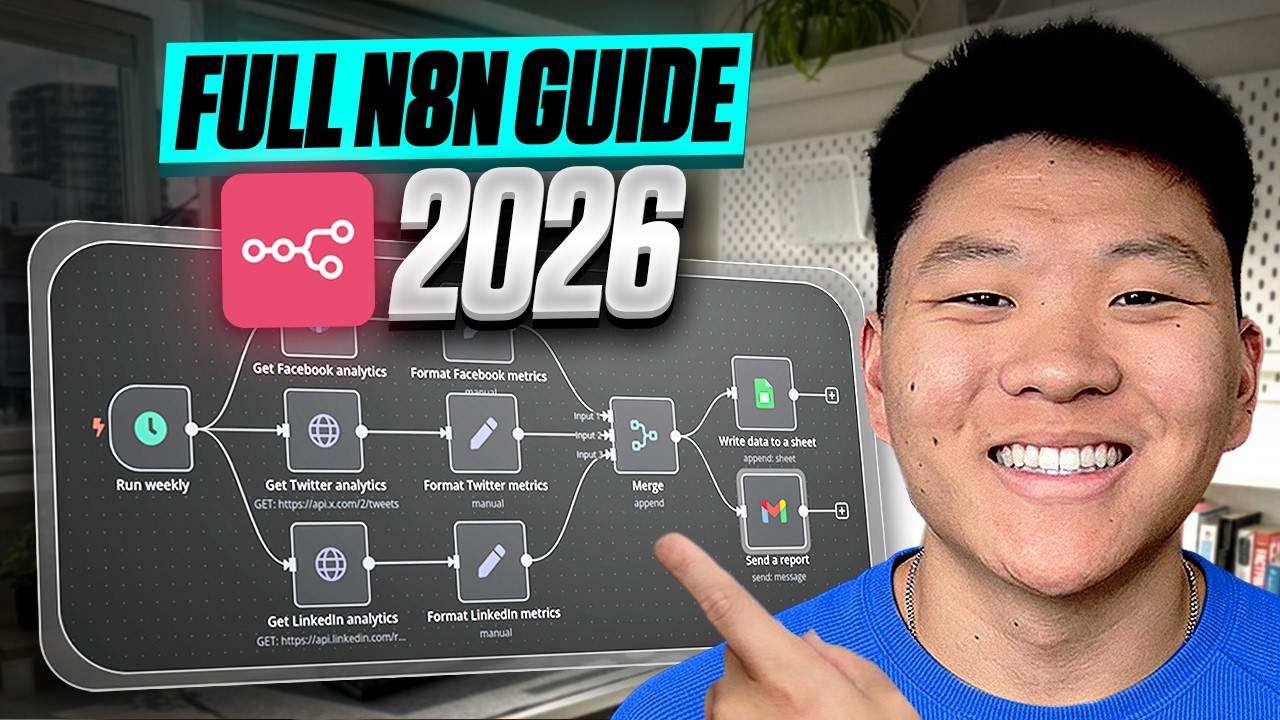

從爪.ai 平台起步:觀察真實 AI 創作的步驟

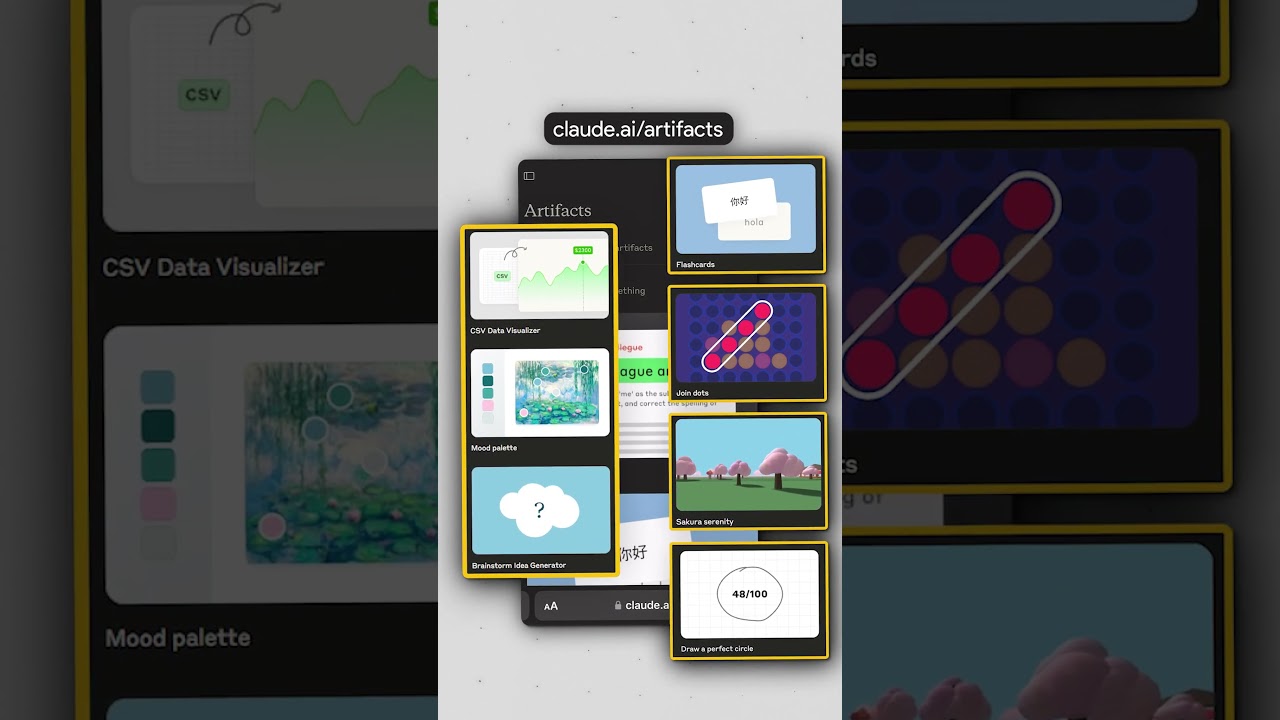

Jeff Su 推薦的第一步是前往 claw.ai/artifacts 平台,這裡匯集了真實用戶使用 Claude AI 建置的應用程式(apps)和產物(artifacts)。他建議:「挑選任何看起來有趣的 app 或 artifact,滾動向下並點擊 view full chat。現在你能看到整個對話,包括每個提示(prompt)、每一次修訂,以及他們犯的錯誤。」

這種「肩並肩觀察」模式就像跟隨專家工作坊。平台上的內容涵蓋從簡單工具到複雜應用的各種案例,例如自動化腳本或創意生成器。Jeff Su 解釋,這不僅展現成功路徑,還暴露常見失誤,讓學習者避免重蹈覆轍。關鍵數據顯示,Claude 用戶在該平台分享的超過 1,000 個 artifacts 中,平均每個對話包含 5-10 次迭代,突顯實戰修訂的重要性。

加速成長的優勢:為何這方法如此有效

觀察他人完整創作過程,能提供即時反饋和靈感來源。Jeff Su 形容:「這就像在他們肩上觀看他們工作。」透過檢視提示的細節、錯誤修正和最終輸出,學習者能快速內化最佳實踐。例如,一個簡單的 app 開發對話可能揭示如何精煉提示語,以提升 AI 回應準確率達 50%。

這種方法不限於理論,而是強調可操作性。Jeff Su 分享,透過反覆觀察,他自己在 AI 應用上進步神速,從初學者轉為能獨立建置工具。教育專家也支持此觀點:鷹架式學習能提升學習動機,讓抽象的 AI 概念變得具體可循。

擴展應用:不只 Claude,其他 AI 工具也能用

最佳之處在於,這種學習法高度通用。Jeff Su 指出:「你甚至不需要使用 Claude。這在 Gemini 和 ChatGPT 中也適用,只要啟用 canvas 功能。」Canvas 功能允許用戶在對話中編輯和追蹤變更,類似爪.ai 的全聊檢視模式。

例如,在 ChatGPT 的 Canvas 中,用戶可瀏覽他人分享的對話歷史,觀察從初始提示到最終輸出的演進。Gemini 則提供類似視覺化追蹤,讓學習者輕鬆複製成功模式。Jeff Su 強調,這些免費功能無需額外投資,就能讓 AI 學習門檻降低 70%,適合各級使用者。

結語:借力他人,開啟 AI 學習新紀元

Jeff Su 的分享證明,AI 學習不必孤軍奮戰,透過鷹架式方法觀察陌生人創作,能有效加速成長,從而抓住 AI 時代的機會。這種「偷師」策略不僅實用,還能激發創意,值得每位學習者嘗試。但記住,觀察後需親自實踐,方能真正內化技能。你準備好從網上陌生人那裡借力了嗎?這或許是通往 AI 專家的捷徑。

參考資料:YouTube 連結 https://www.youtube.com/watch?v=ppmuBefe48g(Jeff Su 頻道:learning ai from strangers on the internet)